L’A/B testing è un metodo per confrontare due versioni di un’attività di marketing, come una landing page, un’headline o una CTA, per vedere quale ha un rendimento migliore. È uno dei metodi più efficaci per migliorare i tassi di conversione perché si basa sul comportamento reale degli utenti, non su ipotesi.

I marketer utilizzano i test A/B per convalidare le idee, ottimizzare le campagne e prendere decisioni basate sui dati. E poiché i landing pages sono costruiti con un unico obiettivo in mente – che si tratti di iscrizioni, acquisti o richieste di demo – sono il luogo ideale per eseguire esperimenti mirati e di grande impatto. Anche piccoli cambiamenti, come la copia dei pulsanti o il layout dei moduli, possono portare a grandi risultati.

In questo post, vedrete esempi reali di test A/B, da semplici modifiche ai titoli a revisioni complete del layout, in modo che possiate imparare cosa funziona, perché funziona e come applicarlo ai vostri landing pages.

Che cos’è il test A/B?

L’A/B testing è un metodo basato sui dati che consente di confrontare due o più versioni di una pagina web o di un’applicazione per determinare quella che funziona meglio. Viene comunemente utilizzato per migliorare l’esperienza dell’utente e aumentare i tassi di conversione identificando il design, il copy o il layout più efficace.

Secondo Adelina Karpenkova in “A/B Testing in Marketing: The Best Practices Revealed”, l ‘A/B testing è una parte fondamentale del processo di ottimizzazione del tasso di conversione (CRO). Consiste nel mostrare due versioni di contenuti quasi identici a un pubblico simile, cambiando solo una variabile per misurare l’impatto.

Dennis van der Heijden, nell’articolo di CXL “5 Things We Learned from Analyzing 28,304 Experiments” (5 cose che abbiamo imparato analizzando 28,304 esperimenti), riferisce che i test A/B rappresentano il 97,5% di tutti gli esperimenti sulla loro piattaforma. La popolarità dei test A/B deriva dal loro successo ripetibile e dal loro comprovato impatto sul miglioramento dei ricavi e delle conversioni.

Dove si utilizzano i test A/B?

I test A/B sono ampiamente utilizzati in tutti i settori per migliorare le prestazioni digitali attraverso i dati reali degli utenti. Le aree di applicazione più comuni includono:

- Commercio elettronico: Testare i layout delle pagine dei prodotti, la visualizzazione dei prezzi o i pulsanti CTA.

- SaaS: Ottimizzazione dei flussi di onboarding, delle landing pages e delle descrizioni delle caratteristiche.

- Pubblicazione: confronto di titoli, layout di articoli o offerte di abbonamento.

- Applicazioni mobili: verifica della navigazione, del posizionamento delle funzioni o della tempistica delle notifiche.

- Marketing via e-mail: Affinare le righe degli oggetti, l’ordine dei contenuti o i tempi di invio.

- Social media: Testare creazioni pubblicitarie, didascalie o strategie di targeting del pubblico.

Creare e testare una nuova versione di una pagina rispetto all’originale aiuta le aziende ad aumentare i tassi di conversione e a migliorare l’esperienza dell’utente. Ciò è particolarmente utile per i siti con più pagine, dove un’ottimizzazione coerente può avere un impatto significativo sulle prestazioni complessive.

Quali sono i vantaggi dei test A/B?

I test A/B aiutano a eliminare le congetture e supportano le decisioni basate su risultati misurabili. Consente alle aziende di ottimizzare le prestazioni digitali e di ottenere risultati migliori su siti web, app e campagne.

Ecco i dieci vantaggi principali dei test A/B:

- Miglioramento dell’esperienza utente (UX). La sperimentazione di variazioni di contenuti, layout o funzionalità rivela ciò che gli utenti trovano più intuitivo. Una migliore UX aumenta la soddisfazione e la fidelizzazione.

- Decisioni guidate dai dati. I test A/B sostituiscono le ipotesi con i dati reali sulle prestazioni, consentendovi di apportare modifiche informate in linea con il comportamento del pubblico.

- Aumento dei tassi di conversione. Identificando gli elementi della pagina ad alto rendimento, è possibile aumentare le vendite, le iscrizioni o altre azioni chiave.

- Riduzione della frequenza di rimbalzo. Quando i contenuti sono più in linea con le aspettative degli utenti, soprattutto su mobile, i visitatori rimangono più a lungo, riducendo la frequenza di rimbalzo.

- Ottimizzazione economicamente vantaggiosa. I test prevengono gli sprechi convalidando le modifiche prima del rollout completo, evitando di investire in idee che non funzionano.

- Rischio ridotto. Piuttosto che lanciare grandi cambiamenti in tutto il sito, i test A/B consentono un rollout graduale, riducendo al minimo il potenziale impatto negativo.

- Miglioramento del coinvolgimento dei contenuti. Testare titoli, immagini o formattazioni diverse aiuta a determinare ciò che mantiene gli utenti impegnati e sulla pagina.

- Migliore ritorno sugli investimenti (ROI). L’ottimizzazione dei landing pages e degli annunci porta a tassi di conversione più elevati, rendendo più efficace la spesa di marketing.

- Approfondimento delle preferenze del pubblico. Con il tempo, i test A/B rivelano i modelli di comportamento degli utenti, consentendo strategie più mirate ed efficaci.

- Miglioramento continuo. I test A/B incoraggiano la sperimentazione e il perfezionamento continui, che portano a incrementi sostenuti delle prestazioni.

Secondo il rapporto State of Conversion Optimization 2020 di CXL, i test A/B sono una delle strategie CRO più efficaci. Smriti Chawla, in CRO Industry Insights di VWO, osserva che i test A/B statisticamente significativi hanno aumentato i tassi di conversione in media del 49%.

Quali sono gli svantaggi dei test A/B?

Lo svantaggio principale dei test A/B èil rischio di creare esperienze utente incoerenti, soprattutto se i test vengono eseguiti troppo frequentemente o senza un’adeguata pianificazione. Test mal eseguiti possono confondere o frustrare gli utenti, riducendo in ultima analisi la fiducia e il coinvolgimento.

Le insidie più comuni includono:

- Test affrettati: L’avvio di test senza un’attenta progettazione può portare a dati inaffidabili e a risultati inefficaci.

- Ignorare la significatività statistica: Trarre conclusioni da dati incompleti può portare a decisioni basate su variazioni casuali piuttosto che su differenze reali.

- Agire su risultati non conclusivi: Apportare modifiche prima che un test raggiunga conclusioni valide può influenzare i test futuri e fuorviare il monitoraggio delle prestazioni.

Per evitare questi problemi, assicuratevi che ogni test abbia una durata sufficiente a raggiungere la significatività statistica, che utilizzi un campione di dimensioni sufficienti e che non venga modificato a metà del processo. La pazienza e la corretta impostazione sono essenziali per produrre informazioni affidabili e attuabili.

Elementi comuni testati nei test A/B

I test A/B si concentrano in genere su elementi che influenzano direttamente il comportamento degli utenti e i tassi di conversione. I componenti più comunemente testati sono:

- Titoli e intestazioni: Questi sono spesso i primi elementi che gli utenti vedono e possono influenzare il fatto che continuino a impegnarsi.

- Pulsanti Call-to-Action (CTA): Variazioni nella formulazione, nel colore, nelle dimensioni e nel posizionamento possono influenzare in modo significativo il tasso di clic.

- Design: Il layout, le immagini e la gerarchia dei contenuti sono spesso testati per determinare ciò che tiene impegnati gli utenti.

- Variazioni delle campagne e-mail: Le linee dell’oggetto, i nomi dei mittenti, la struttura dei contenuti e la tempistica possono influenzare i tassi di apertura e di clic.

Altri elementi frequentemente testati sono:

- Moduli di iscrizione: La regolazione del numero di campi o delle etichette dei campi può influire sui tassi di completamento.

- Sezioni di prova sociale: La modifica di recensioni, testimonianze o badge di fiducia può influenzare la credibilità e la conversione.

- Copia dell’annuncio: Piccoli cambiamenti nella formulazione possono influenzare il coinvolgimento e l’efficienza dei costi nelle campagne a pagamento.

La chiave del successo dei test A/B consiste nel dare priorità agli elementi che hanno maggiori probabilità di influenzare gli obiettivi di conversione specifici.

Analizziamo in dettaglio gli elementi più diffusi.

Titoli e intestazioni dei siti web

Un titolo forte gioca un ruolo fondamentale nell’attrarre e trattenere i visitatori di un sito web. I test A/B aiutano a identificare le formulazioni e i toni che risuonano meglio con il pubblico, consentendo di confrontare le variazioni di stile, messaggio e formulazione.

L’ottimizzazione dei titoli attraverso i test può portare a tassi di clic più elevati, a un maggiore coinvolgimento e a un miglioramento delle prestazioni del sito. Secondo HubSpot, la verifica dei titoli può aumentare i tassi di clic fino al 10%.

Pulsanti di invito all’azione (CTA)

I pulsanti CTA sono essenziali per guidare gli utenti verso la conversione. I test A/B consentono di confrontare le variazioni di testo, colore, dimensione, design e posizionamento dei pulsanti per determinare la versione che produce risultati migliori.

Anche piccoli aggiustamenti possono influenzare il comportamento degli utenti e migliorare i tassi di conversione. Secondo ConvertVerve, testare i pulsanti CTA può aumentare i tassi di conversione del 14,79%.

landing page Disegni

Una landing page ben strutturata ha un impatto diretto sull’esperienza dell’utente e sui tassi di conversione. I test A/B e multivariati si concentrano spesso su elementi quali:

- Layout della pagina

- Titoli e sottotitoli

- Copia del corpo

- Visualizzazione dei prezzi

- Pulsanti CTA

- Flusso di iscrizione

- Lunghezza del modulo

- Elementi visivi

Testare diversi design landing page aiuta a identificare quali elementi favoriscono il coinvolgimento degli utenti e le conversioni, e quali invece creano attrito o confusione. Questo processo di miglioramento continuo porta a una migliore qualità dei lead e a tassi di conversione più elevati.

Secondo MarketingExperiments, l’ottimizzazione del design landing page può aumentare le conversioni fino al 30%.

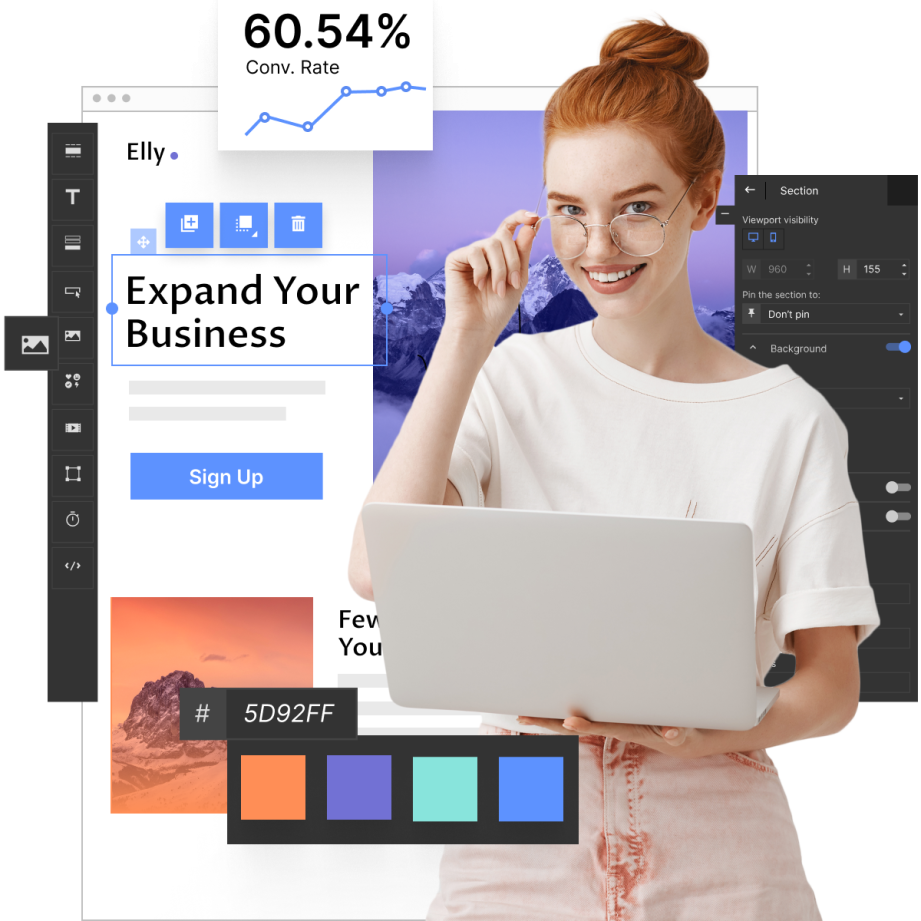

Landingi, un costruttore di landing page dedicato, supporta questo processo di ottimizzazione. La sua interfaccia intuitiva e gli strumenti di test integrati consentono di creare, duplicare e testare facilmente le variazioni per migliorare le prestazioni.

Variazioni delle campagne e-mail

Le campagne e-mail sono una componente fondamentale del marketing digitale e i test A/B aiutano a ottimizzarne le prestazioni. Testando diverse versioni di oggetto, struttura dei contenuti o tempi di invio, è possibile identificare quali sono i fattori che determinano tassi di apertura e di clic più elevati.

I test A/B affinano la strategia di invio delle e-mail utilizzando i dati reali degli utenti, eliminando le congetture e migliorando i risultati.

Esempio:

Un marchio di gioielli artigianali vuole trovare l’oggetto più efficace per la sua newsletter. Crea due versioni di e-mail identiche, tranne che per l’oggetto:

- Versione A: “Nuova collezione: Gioielli fatti a mano solo per voi”.

- Versione B: “Scoprite il vostro nuovo pezzo preferito”.

Ogni versione viene inviata a un segmento di pubblico diverso. L’oggetto con il tasso di apertura più alto viene utilizzato nelle campagne future per aumentare il coinvolgimento e le vendite potenziali.

Secondo Campaign Monitor, testare le variazioni delle e-mail può aumentare i ricavi delle e-mail fino al 20%.

Perché i landing pages sono il fulcro delle strategie di A/B Testing?

I test A/B sono ideali perché offrono un ambiente mirato e orientato alla conversione. Sia che si tratti di testare titoli, CTA, lunghezza dei moduli, immagini o schemi di colori, le landing pages consentono di isolare le variabili e di vedere quali elementi influenzano realmente il comportamento degli utenti. Queste condizioni controllate portano a decisioni chiare e fondate su dati piuttosto che su ipotesi.

Poiché i landing pages rappresentano spesso l’ultimo passo prima della conversione, anche piccoli miglioramenti possono avere un impatto immediato sul ROI.

Costruite varianti, eseguite test A/B senza il supporto di sviluppatori e ottimizzate le pagine in base ai dati in tempo reale.

1. Esempio di test A/B

I landing pages sono tra gli asset più frequentemente testati nel marketing. Un esempio significativo viene da ForestView, un’agenzia digitale con sede ad Atene, in Grecia, che ha condotto un test A/B per migliorare le prestazioni di un cliente.

Il team ha ipotizzato che, riducendo la necessità di un eccessivo scorrimento, gli utenti avrebbero trovato più facilmente i prodotti, aumentando così le conversioni dei moduli. Per verificarlo, hanno ridisegnato la pagina con due modifiche fondamentali:

- Sostituzione di un lungo elenco di prodotti con dei caroselli

- Introduzione del filtraggio multilivello per la scoperta dinamica dei prodotti

Il test A/B è durato 14 giorni con oltre 5.000 visitatori suddivisi equamente tra la versione originale (controllo) e quella ridisegnata (variazione).

Risultati:

- Conversioni dei moduli da mobile: ↑ 20.45%

- Conversioni di moduli desktop: ↑ 8.50%

- Coinvolgimento degli utenti: ↑ 70.92%

I risultati hanno confermato l’ipotesi: una navigazione più snella e un filtraggio mirato hanno migliorato sia l’usabilità che i tassi di conversione.

2. Esempio di test A/B SaaS

Nel settore SaaS, i test A/B svolgono un ruolo fondamentale nell’ottimizzazione del design dei siti web e nel miglioramento delle conversioni. Un caso di studio tratto dal blog Signal v. Noise di Basecamp evidenzia lo split testing condotto sul sito di marketing di Highrise.

Il team ha ipotizzato che un layout semplificato, chiamato “Person Page”, avrebbesuperato una versione più lunga e dettagliata, chiamata “Long Form”. Per verificarlo, hanno condotto un esperimento A/B di confronto tra i due.

Risultati chiave:

- La “Person Page” ha aumentato le iscrizioni a pagamento del 47% rispetto al design “Long Form”.

- Rispetto al progetto originale (prima di entrambe le versioni), l’aumento è stato del 102,5%.

- Tuttavia, quando sono stati aggiunti ulteriori contenuti alla “Pagina personale”, le conversioni sono diminuite del 22%.

In un test separato, il team ha esaminato l’effetto dell’utilizzo di foto dei clienti. È emerso che le immagini di clienti grandi e sorridenti aumentavano le conversioni, anche se la persona specifica ritratta non faceva alcuna differenza significativa.

Questi test A/B, condotti per diverse settimane, hanno aiutato il team a mettere in discussione le ipotesi e a scoprire quali elementi del design influenzassero realmente il comportamento degli utenti. La chiave di lettura è che i test a secchiate rivelano ciò che funziona, anche quando è in contrasto con le aspettative.

3. Esempio di test A/B nel settore immobiliare

Il settore immobiliare dipende fortemente dall’ottimizzazione delle esperienze digitali. Piattaforme leader come Zillow, Trulia e StreetEasy utilizzano i test A/B per migliorare l’usabilità e rispondere meglio alle esigenze degli utenti. Come evidenziato nell’articolo di Anadea “How Effective A/B Testing Helps to Build a Cool Real Estate App”, StreetEasy ha eseguito dei test per adattare la sua esperienza di ricerca agli utenti di New York City.

I punti salienti del test A/B di StreetEasy:

La piattaforma ha testato diverse opzioni di filtro per la ricerca e ha scoperto che gli utenti preferiscono filtrare per quartiere e tipo di edificio. A NYC, la posizione e lo stile dell’immobile sono fattori importanti nel processo decisionale. Ad esempio, chi conosce Tribeca potrebbe non prendere in considerazione un appartamento a Chinatown, anche se corrisponde alle sue preferenze.

Il contenuto visivo è importante:

Le immagini degli annunci sono fondamentali per il coinvolgimento degli utenti. StreetEasy ha osservato che i visitatori passano circa il 60% del loro tempo a vedere le foto degli annunci, rendendo le dimensioni e la presentazione delle immagini un elemento critico da testare e ottimizzare.

Impatto del linguaggio descrittivo:

Zillow ha condotto uno studio su 24.000 vendite di case e ha scoperto che parole chiave specifiche nelle descrizioni degli annunci, come “lussuoso”, “paesaggistico” e “migliorato”, sono correlatea prezzi di vendita più elevati. Ciò suggerisce che la formulazione può influenzare direttamente la conversione e il valore percepito dell’immobile.

4. Esempio di test A/B per applicazioni mobili

Mentre l’ottimizzazione delle applicazioni mobili diventa sempre più importante, i test A/B giocano un ruolo chiave nel plasmare le esperienze in-app e le strategie di monetizzazione. Un caso degno di nota è quello di AppQuantum e Red Machine, che hanno collaborato ai test A/B per Doorman Story, un gioco a gestione del tempo in cui i giocatori gestiscono un hotel. Questo caso è descritto in dettaglio nell’articolo di Medium “How to Conduct A/B Tests in Mobile Apps: Parte I”.

Obiettivo del test:

Il team ha testato se l’aggiunta di una meccanica di gioco a pagamento, unamacchina per masticare gomme, potesse diventare una funzione di monetizzazione fattibile. A differenza di giochi simili che offrono tali funzionalità gratuitamente, questa versione ha introdotto la meccanica dietro un paywall in livelli selezionati. È stata prestata attenzione a non alterare il bilanciamento del gioco.

Approfondimento chiave:

L’obiettivo era misurare la risposta dei giocatori a questo elemento a pagamento e se fosse percepito come valido. Una delle preoccupazioni principali era l’abbandono degli utenti se i giocatori avessero rifiutato di pagare per strumenti precedentemente gratuiti.

Risultati:

Il test A/B ha rivelato che la versione più semplice della meccanica ha ottenuto i risultati migliori. Questo risultato ha messo in discussione le ipotesi iniziali e ha dimostrato che la semplicità può superare modelli di monetizzazione più complessi.

Conclusione:

Questo test evidenzia l’importanza dei test A/B nelle applicazioni mobili, soprattutto per la monetizzazione. Testando il comportamento dei giocatori prima del lancio completo, il team ha evitato di allontanare potenzialmente gli utenti e ha identificato l’approccio più efficace.

5. Esempio di test A/B di email marketing

MailerLite ha condotto diversi test A/B per migliorare le prestazioni delle e-mail, come illustrato nell’articolo di Jonas Fischer, “Esempi di A/B Testing Email Marketing per migliorare le campagne, landing pages e altro”. Gli esperimenti si sono concentrati sulla lunghezza dell’oggetto, sull’uso di emoji, sulle aperture basate su domande, sul posizionamento delle immagini e sulle prestazioni dell’automazione.

Uso di emoji nelle righe dell’oggetto

Nei primi test, gli emoji hanno avuto un effetto limitato. Ad esempio, nel 2020:

- Con emoji: tasso di apertura del 31,82%.

- Senza emoji: tasso di apertura del 31,93%.

Tuttavia, test ripetuti hanno mostrato un cambiamento nel tempo. Negli esperimenti successivi:

- Con emoji: tasso di apertura del 37,33%.

- Senza emoji: tasso di apertura del 36,87%.

Ciò indica che l’efficacia delle emoji può evolvere in base alla familiarità del pubblico e alle tendenze più ampie delle e-mail.

Lunghezza dell’oggetto

MailerLite ha anche testato l’impatto di un oggetto conciso rispetto a uno lungo. I risultati hanno mostrato che gli oggetti più brevi hanno portato a un maggiore coinvolgimento, tra cui:

- Fino al 100% di tasso di apertura

- 85,71% di tasso di clic

Questi risultati evidenziano l’importanza di testare continuamente anche elementi minori per rimanere in linea con le preferenze del pubblico.

6. Esempio di test A/B per il commercio elettronico

Un articolo di Tomer Dean, “The Battle of Conversion Rates – User Generated Content vs Stock Photos” (La battaglia dei tassi di conversione: contenuti generati dagli utenti e foto di repertorio), ha analizzato l’impatto dei diversi tipi di immagini sulle prestazioni dell’e-commerce, in particolare nel settore della moda e dell’abbigliamento.

Focus del test:

La campagna di test A/B ha messo a confronto i contenuti generati dagli utenti (UGC)– foto di persone reali che indossano i prodotti – con le tradizionali fotografie di stock.

Risultati chiave:

- Per un reggiseno sportivo Nike, un’immagine UGC di Instagram ha ottenuto un tasso di conversione dello 0,90%, rispetto allo 0,31% della foto stock.

- Una landing page per i tacchi alti rossi che combinava un’immagine stock con tre immagini UGC ha superato significativamente la versione che utilizzava solo una foto stock.

- Ulteriori test con prodotti come una gonna di Zara e scarpe da corsa di Nike hanno mostrato tendenze simili, anche se con alcune variazioni a seconda del tipo di prodotto.

Questi test hanno dimostrato che le immagini autentiche possono superare le immagini di repertorio più curate nel guidare le conversioni. Tuttavia, lo studio ha anche sottolineato la necessità di effettuare test continui e di attenersi agli standard di licenza e copyright delle immagini quando si utilizzano gli UGC.

Secondo Smriti Chawla in “CRO Industry Insights from Our In-App Survey Results” di VWO , i siti di e-commerce generano in media 3 dollari per visitatore unico, e un test A/B ben eseguito può aumentare questa cifra fino al 50%.

Il test A/B può essere applicato a ogni elemento di un sito web?

Tecnicamente, i test A/B possono essere applicati a qualsiasi elemento. Tuttavia, è più efficace dare priorità agli elementi che hanno il maggiore impatto sul comportamento degli utenti e sui tassi di conversione, come i titoli, le CTA, i moduli e le funzioni di navigazione principali. I test mirati assicurano che le risorse siano concentrate dove offrono il massimo valore.

C’è il rischio di allontanare gli utenti con frequenti test A/B?

Sì. Se i test A/B vengono eseguiti troppo spesso o senza tenere conto dell’esperienza dell’utente, possono causare confusione o frustrazione. Per evitarlo, eseguite i test in modo ponderato e mantenete la coerenza tra le funzioni principali del sito. Bilanciate la sperimentazione con un’esperienza stabile e facile da usare.

Che cos’è un gruppo di controllo nei test A/B?

Un gruppo di controllo è la versione originale di una pagina web, di un’applicazione o di un elemento usato come base in un test A/B. Fornisce un punto di riferimento per misurare l’impatto delle modifiche apportate alla variazione del test.

Cosa costituisce un risultato statisticamente significativo nei test A/B?

Un risultato statisticamente significativo significa che è improbabile che la differenza osservata tra il controllo e la variazione sia dovuta al caso. La maggior parte dei test A/B utilizza un livello di confidenza del 95%, il che significa che c’è solo il 5% di probabilità che il risultato si sia verificato casualmente.

Quale percentuale di test A/B/x fallisce?

Secondo il CRO Industry Insights di Smriti Chawla di VWO, solo il 14% dei test A/B si traduce in vittorie statisticamente significative, il che significa che l’86% non riesce a produrre un miglioramento misurabile dei tassi di conversione. Una ricerca di Convert.com conferma risultati simili. Tuttavia, i tassi di fallimento possono variare a seconda del settore, delle dimensioni del pubblico e della complessità del test.

Quali sono gli strumenti più utilizzati per i test A/B?

Gli strumenti di test A/B comunemente utilizzati includono:

- Ottimizzare

- VWO (Visual Website Optimizer)

- Google Optimize (tramonta nel 2023 ma è ancora referenziato)

- Adobe Target

- AB Tasty

Queste piattaforme consentono alle aziende di progettare, eseguire e analizzare i test A/B, offrendo funzionalità quali il targeting, i test multivariati e una reportistica dettagliata.

Cosa ha un impatto più profondo sul comportamento dell’utente: cambiare il colore della CTA o il suo testo?

Iltesto della CTA ha in genere un effetto più profondo, in quanto influenza direttamente il modo in cui gli utenti interpretano e rispondono all’azione richiesta. Mentre il colore può migliorare la visibilità, la formulazione dà forma all’intenzione e all’urgenza.

- Uno studio di HubSpot condotto da Joshua Porter ha dimostrato che cambiare il colore di un pulsante (rosso o verde) aumenta le conversioni del 21%.

- Una ricerca di Melanie Deziel ha rilevato che un testo CTA personalizzato può migliorare i tassi di conversione fino al 202%.

In sintesi, mentre il colore è importante dal punto di vista visivo, il testo ha un’influenza maggiore sul comportamento degli utenti e sulle prestazioni di conversione complessive.

Quali sono i settori che beneficiano maggiormente dei test A/B?

I settori che traggono il massimo vantaggio dai test A/B sono i seguenti:

- E-commerce: ottimizzazione delle pagine dei prodotti, della visualizzazione dei prezzi e dei flussi di pagamento.

- SaaS – miglioramento dei processi di iscrizione, dei flussi di onboarding e della messaggistica sulle funzionalità

- Marketing digitale: perfezionamento di campagne e-mail, landing pages e performance degli annunci.

- Sviluppo di app per dispositivi mobili: miglioramento dell’UI/UX, acquisti in-app e strategie di fidelizzazione.

Questi settori traggono vantaggio dall’utilizzo dei test A/B per migliorare l’esperienza dell’utente, aumentare le conversioni e prendere decisioni informate e basate sui dati.

Che cos’è l’A/B testing nell’esempio del marketing?

L’A/B testing nel marketing consiste nel confrontare diverse versioni di campagne, come creazioni pubblicitarie, titoli o messaggi, per identificare quella che ha un rendimento migliore. Testando sistematicamente le variazioni, le aziende possono determinare cosa risuona maggiormente con il loro pubblico e migliorare i tassi di coinvolgimento o di conversione. I test frequenti aiutano anche a perfezionare la strategia e a prendere decisioni più efficaci e basate sui dati.

Qual è un esempio di A/B testing sui social media?

L’A/B testing sui social media prevede il confronto di variabili come le immagini degli annunci, le didascalie o il targeting del pubblico. Ad esempio, un’azienda potrebbe testare due annunci su Facebook, uno che utilizza una foto del prodotto e l’altro che utilizza contenuti generati dagli utenti, per vedere quale versione fa registrare più clic o conversioni con un segmento di pubblico specifico.

Perché usiamo i test A/B?

I test A/B aiutano gli addetti al marketing a prendere decisioni basate sui dati, a migliorare l’esperienza degli utenti e ad aumentare i tassi di conversione. Testando diverse versioni di pagine web, applicazioni o campagne, le aziende possono identificare ciò che funziona meglio, ottimizzare le prestazioni e migliorare il ritorno sugli investimenti.

Il test A/B è un KPI?

L’A/B testing non è un KPI vero e proprio, ma un metodo utilizzato per influenzare e misurare KPI come il tasso di conversione, la frequenza di clic o la frequenza di rimbalzo. Fornisce indicazioni sul modo in cui modifiche specifiche influenzano il comportamento degli utenti e aiuta a identificare le strategie che portano a risultati misurabili.

Qual è un esempio di A/B testing nella vita reale?

Un esempio reale di A/B testing è il confronto tra due design di confezioni di prodotti per vedere quale porta a maggiori vendite. Altri esempi sono quelli di testare diversi layout di negozio o strategie di prezzo per determinare quale versione migliora l’esperienza del cliente o aumenta i ricavi.

Cosa sono i campioni A/B?

I campioni A/B si riferiscono alle due versioni utilizzate in un test: il controllo (versione originale) e la variazione (versione modificata). Il confronto delle loro prestazioni aiuta a identificare quale versione supporta meglio gli obiettivi, come un maggiore coinvolgimento o una maggiore conversione.

Quante aziende utilizzano i test A/B?

Secondo il rapporto State of Conversion Optimization 2020 del CXL Institute, il 44% delle aziende intervistate utilizza software di A/B testing. Lo studio ha incluso 333 aziende di varie dimensioni in diversi settori.

L’adozione è particolarmente comune nei settori con forti operazioni digitali, come l’e-commerce e il SaaS. Un rapporto separato di Econsultancy del 2019 ha rilevato che il 77% delle aziende con programmi CRO strutturati utilizza regolarmente l’A/B testing.

Come utilizza Netflix i test A/B?

Netflix utilizza i test A/B per migliorare l’esperienza dell’utente testando elementi quali:

- Miniature per spettacoli e film

- Layout dell’interfaccia utente

- Algoritmi di raccomandazione personalizzata

- Anteprima delle impostazioni di autoplay

L’obiettivo è identificare quali versioni aumentano il coinvolgimento, la fidelizzazione e il tempo complessivo di visualizzazione degli utenti.

YouTube dispone di test A/B?

YouTube non offre strumenti di test A/B per i creatori. Tuttavia, YouTube stesso conduce regolarmente test A/B interni per migliorare le funzionalità della piattaforma e l’esperienza degli utenti. I creatori che vogliono testare le prestazioni dei contenuti devono affidarsi a strumenti esterni o a metodi manuali (ad esempio, testando le miniature o i titoli nel tempo).

Shopify dispone di test A/B?

Shopify non include test A/B integrati, ma i commercianti possono utilizzare applicazioni di terze parti dallo Shopify App Store per eseguire test. Questi strumenti consentono di testare elementi come le pagine dei prodotti, i prezzi e i flussi di pagamento.

Mailchimp può effettuare test A/B?

Sì. Mailchimp offre funzioni di A/B testing che consentono agli utenti di confrontare le righe dell’oggetto, i contenuti delle e-mail e i tempi di invio per migliorare i tassi di apertura e di clic.

Wix può fare test A/B?

Wix non offre test A/B nativi. Tuttavia, gli utenti possono integrare strumenti di terze parti come Google Optimize per eseguire test sui loro siti web. Questi strumenti consentono agli utenti di Wix di testare il layout, i contenuti e gli elementi di design per migliorare le conversioni e il coinvolgimento degli utenti.

Google effettua test A/B?

Sì. Google conduce regolarmente test A/B e multivariati sui suoi prodotti e servizi per valutare le modifiche alle funzionalità, gli aggiornamenti dell’interfaccia e i miglioramenti dell’algoritmo. Questi test aiutano a garantire che le nuove implementazioni soddisfino gli obiettivi di performance e di esperienza utente.

Come effettuare i test A/B con Google Ads?

Per eseguire un test A/B in Google Ads:

- Selezionate la variabile da testare (ad esempio, copia dell’annuncio, parole chiave o landing page).

- Creare due versioni dell’annuncio, unaoriginale (di controllo) e una variante.

- Eseguire entrambi gli annunci contemporaneamente in condizioni simili.

- Analizzare i dati sulle prestazioni (CTR, conversioni, ecc.) per determinare la versione vincente.

Come condurre un test A/B in Excel?

Per eseguire un test A/B in Excel:

- Utilizzare la funzione T.TEST di Excel per determinare se la differenza tra i gruppi è statisticamente significativa.

- Organizzare i dati in due gruppi: controllo (A) e variazione (B).

- Calcolare la media e la deviazione standard per ciascun gruppo.

Quanti dati sono necessari per il test A/B?

La dimensione del campione richiesto dipende dal livello di confidenza desiderato, dalla dimensione dell’effetto atteso e dal volume di traffico. Come linea guida generale, puntate ad almeno 100 conversioni per variazione per rilevare differenze significative. Un traffico più elevato e una durata maggiore dei test migliorano l’affidabilità.

I test A/B sono costosi?

I costi variano in base agli strumenti, alla complessità e a chi esegue il test.

- Strumentigratuiti: Alcune piattaforme offrono funzioni di base per i test A/B senza alcun costo.

- Strumentia pagamento: Gli strumenti avanzati possono richiedere un canone mensile o basato sull’utilizzo.

- In-house vs. outsourcing: L’esecuzione dei test internamente è spesso più conveniente, mentre l’outsourcing può comportare costi più elevati ma offrire una guida strategica.

Creare campagne migliori con test A/B basati sui dati su landing pages

Il test A/B è più di uno strumento: è una mentalità incentrata sul miglioramento continuo. Consente agli esperti di marketing di prendere decisioni informate e basate su dati che perfezionano le campagne e migliorano i risultati. Sia che si tratti di testare un pulsante CTA, un layout landing page o una variante di un’e-mail, i test A/B aiutano a identificare ciò che realmente determina il coinvolgimento e le conversioni.

Con l’aumento della concorrenza digitale, il ruolo dello split testing nel migliorare l’esperienza dell’utente e nel guidare i risultati di business continua a crescere.

Piattaforme come Landingi hanno democratizzato l’accesso a questo potente strumento, consentendo alle aziende di tutte le dimensioni di condurre esperimenti approfonditi. Con Landingi, è possibile creare una grande campagna e ottimizzarla con test multivariati, programmatore di campagne, sostituzione dinamica del testo e opzioni di personalizzazione per ottenere i migliori risultati. La cosa più interessante è che potete iniziare a utilizzare la piattaforma Landingi gratuitamente!